- はじめに -

この記事の起点となったのは、2018年1月25日、共同通信が配信した「山中氏、科学誌創刊に深く関与か」というタイトルの記事が、同日午後8時頃「山中所長が給与全額寄付」というタイトルの記事に書き換えられていた件である。

下記ツイートの通り、追記や編集の知らせ無しにネットメディアが大幅に修正された場合、記事公開当初と意見の辻褄が合わず、自身の発言に責任が取れなくなる場合がある。

新聞社の件のアレでURLを含む過去のツイート全部出してフィルターかけて消すスクリプト欲しくなってきた…「これは良いですね」とシェアした記事が良くない記事になっている可能性

— ばんくし (@vaaaaanquish) 2018年1月26日

自身が良いと共有した記事が卑猥、卑劣な記事になっている場合を防ぐため、特定のメディアの記事に言及していたツイートを削除するスクリプトについてメモしておく。

事前に必要な要件は以下の通り

- スクリプト -

最初に全体のスクリプト。

API周りのKeyは、http://phiary.me/twitter-api-key-no-japanese から電話番号をアカウントに紐付けた後、https://apps.twitter.com/ にて取得する。

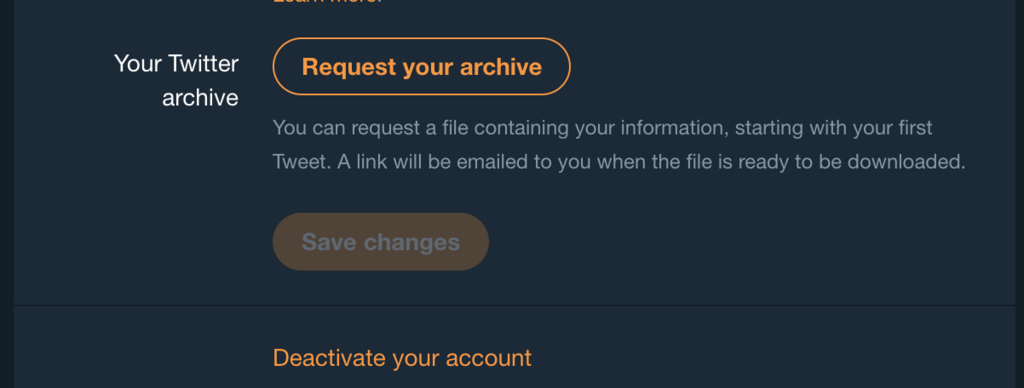

全ツイート情報を含むCSVは、Twitter公式のSettingsから、全ツイート取得の申請を出すと登録しているメールアドレスに30分程でダウンロードリンクが送られてくる。

import tweepy import urllib import csv import urllib.request CONSUMER_KEY = '' CONSUMER_SECRET = '' ACCESS_TOKEN = '' ACCESS_SECRET = '' CSV_PATH = 'tweets.csv' DOMAIN_LIST = ["this.kiji.is", "www.asahi.com"] auth = tweepy.OAuthHandler(CONSUMER_KEY, CONSUMER_SECRET) auth.set_access_token(ACCESS_TOKEN, ACCESS_SECRET) api = tweepy.API(auth) def expand(url): req = urllib.request.Request(url, method='HEAD') resp = urllib.request.urlopen(req) return resp.url def expand_url(url): eurl = expand(url) while eurl != url: url = eurl eurl = expand(url) return eurl def main(): with open(CSV_PATH, 'r') as f: reader = csv.reader(f) header = next(reader) for i, row in enumerate(reader): flag = False for x in list(set(row[9].split(","))): if x != "": try: y = expand_url(x) for domain in DOMAIN_LIST: if urllib.parse.urlparse(y).netloc == domain: flag = True except KeyboardInterrupt: raise except: pass if flag: api.destroy_status(row[0]) if __name__ == '__main__': main()

print等は適宜。

ツイートが削除されるスクリプトなので確かめながら使う。

- 適当な色々 -

以下は駄文である。

このスクリプトを書くにあたっての実験的な色々とか。

短縮URLの展開がurllibだけでできるようになってた

「短縮URL 展開 Python」みたいに適当にググると、Python2系のhttplib.HTTPConnectionを使ってHEADメソッド投げるスクリプトが沢山でてくるのは知ってたけど、3系からurllib.request.RequestでHEADできるの知らなかった。

Python3系で短縮URLを展開するのは以下みたく

import urllib.request root_u = "http://hogehoge" def expand(url): """curl --head url""" req = urllib.request.Request(url, method='HEAD') resp = urllib.request.urlopen(req) return resp.url def expand_url(url): """短縮URLをできるだけ展開する""" eurl = expand(url) while eurl != url: url = eurl eurl = expand(url) return eurl print(root_u, expand_url(root_u))

個人的には使い所は今のところないがハッピーな気がする

CSVの読み込み

CSVは大体30分くらいでメールが来て、ツイート数226Kで40Mくらいのzipになってた。

前回ダウンロードした時より大分大きくなってる気がした。

試しに1000件くらいやってみたけど、割りと接続できないURLがあったので、そちらも削除した方が良いような気がした。

import urllib import csv with open('tweets.csv', 'r') as f: reader = csv.reader(f) header = next(reader) for i, row in enumerate(reader): # 複数URLはカンマ区切り for x in list(set(row[9].split(","))): if x != "": try: y = expand_url(x) print("base: {}\nexpanded: {}\ndomain: {}".format(x, y, urllib.parse.urlparse(y).netloc)) except KeyboardInterrupt: raise except: print("Not Found : ", x) if i > 1000: break

headerはtweet_idとexpanded_urlsしか使ってないけど、textとか時間も考慮した方が良い気がした。

記事の書き換えについて

全体を通して嫌な気分になる話だったが、解決方法が見当たらず難しい問題だと思う。

日本の今の社会形態からして、記者が常に誠実かつ知識を多く習得し続けるというのは難しいだろうし、それらを補正するには専門家の意見を割く事になる。

記者側としても「スピード感持って数多くの読まれる記事を出したい」という気持ちは強いだろうし時間の制約は大きい。

その点ネットでは公開直後から意見が集まる訳なので、今回あくまで修正方法が下衆だったという話にして、今後「指摘があったので修正しました」「間違っていたので差し止めます」が気軽に言える社会になっていけば良いなと思う。

法律の範囲内であれば、間違う事自体は決して悪い事ではない。

- おわりに -

花金の飲み会おわりの勢いで書いた。

間違ってたら修正すればええねん。

追記 2018/01/27 0:14 :

ミスを指摘されたのでサイレントで修正しました。

ばんくし もしかして同日 か? pic.twitter.com/Vd6PhkklkF

— ナポレオンアップルシード (@nappleseed) 2018年1月26日